AIのリスク評価は第三者機関で ~谷脇・元総務審議官に聞く~

生成AI(人工知能)の技術が急速に進歩している。その影響は生産性向上の範囲にとどまらない。ビジネスや科学、芸術など人類の創造性発揮への寄与を通じ、経済社会を一変させる。しかし開発や利用方法を誤ると社会の混乱を招いたり、地政学的緊張を高めたりするリスクも否定できない。2024年12月にAIへのガバナンスについて提言をまとめた産官学の有識者会議「デジタル政策フォーラム」の代表幹事を務める谷脇康彦・元総務審議官=インターネットイニシアティブ(IIJ)副社長(4月社長就任予定)=にAIの研究開発・利用の推進と規制に関するバランスについて聞いた。

インタビューに答える谷脇康彦氏

インタビューに答える谷脇康彦氏

ガイドラインの実効性

――生成AIを中心に規制議論が近年盛り上がりを見せているが。

2017年に総務省がAIに関して開発者らが守るべきガイドラインを作成しようとしたら、余計な政府の介入はイノベーションを阻害するとして他省庁や民間から反発があった。しかし、ルール作りの必要性が広く認識されて国際的な議論が進む中、経済産業省や内閣府でもガイドライン作りが進み、さらに昨年4月に政府としての統合的なAIガイドラインがまとまった(注1)。

国際的にも23年5月の広島G7サミット(先進7カ国首脳会議)で日本が主導したAIに関する国際的なルール作りの枠組み「広島AIプロセス」がまとまり、これに参加する国の数も増加してきている。こうした議論のベースラインは、AIの安全性を担保しつつ、開発意欲を阻害しないようにするということだ。

――ガイドラインでは強制力がなく、実効性がないのでは。

日本のAIガイドラインの特徴はまさにその点にある。政府が制度として直接介入するものではないが、ガイドラインであるが故に、開発者らが本当にその方向に向かうかどうかはわからない。またガイドラインが分厚いものとなり、実効性に疑問符が付くものにもなってきている。

海外の動向を見ると、欧州連合(EU)のAI法はリスクを4段階に分け、罰則(注2)を含む厳しい内容になっている。域外適用の規定もある。日本政府もAI戦略会議でAI関連の開発促進と安全性に関する規制を検討しているが、実際問題としてAIリスクと規制水準をリンクさせる運用は極めて難しいと言わざるを得ない。

| 許容できないリスク | 生命や基本的人権に対する直接的な脅威 | 禁止 |

| ハイリスク | 人の健康や安全、基本的人権、社会的・経済的利益に影響を与える可能性 | 規制 |

| 限定リスク | 深刻なリスクはないが、透明性確保の要件を満たす必要 | 透明性の義務 |

| 最小リスク | EUで利用されるAIの大半 | 規制なし |

欧州AI法におけるリスクへの対応

(出所)EU"Regulatory Framework Proposal on Artificial Intelligence"を基にしたデジタル政策フォーラム「AIガバナンスの枠組みの構築に向けてver2.0」(2024年12月)から作成

厳格な法規制では柔軟な対応が難しい

AIのリスクについて評価軸をどのように誰が定めるのか、評価が恣意(しい)的にならず客観性を保(たも)てるのかなど規制のリスクもある。米マサチューセッツ工科大学(MIT)は2024年8月に過去40以上のAIリスクに関する各種研究を元に700項目を越えるリスクを整理したデータベース「レポジトリー」(デジタル収蔵庫)を公開した。AIリスクは、学習データをとり取り込む時点、学習後の運用時点、再学習させた時点など、それぞれの時点でリスクが変化するなど多面的な側面がある。

特に、学習していく中でモデルが進化し、これに伴ってリスクの量や質が変化していく点は注意を払う必要がある。また、AIが自身で作成した生成物を学習データに再活用する場合、モデル崩壊が起こり、少数意見が無視されるなどのリスクも指摘されている。さらに、AIの不具合が開発者側に責任があるのか、それともAIを組み込んでサービスを提供する事業者側にあるのかなど、責任の所在明確化も重要だ。

規制の枠組みを考える場合、AIの登場によってまさに新たな規制が必要なのか、それとも利用者保護など既存の法的枠組みで対応可能なのか仕分けを十分に行うとともに、開発促進と利用者保護の適正なバランスをどのようにとるのかなど、慎重に検討していく必要がある。基本はライトタッチな規制枠組みとして、例えば基本法的なアプローチと大きな方向性を国が決めて具体的な運用基準は民間の自主的なルールに委ねる共同規制(co-regulation)的なアプローチを組み合わせた柔軟な対応が現実的ではないか。

基本法で官民の全体戦略を統括

――ではどのようなAI関連の法律が必要なのか。

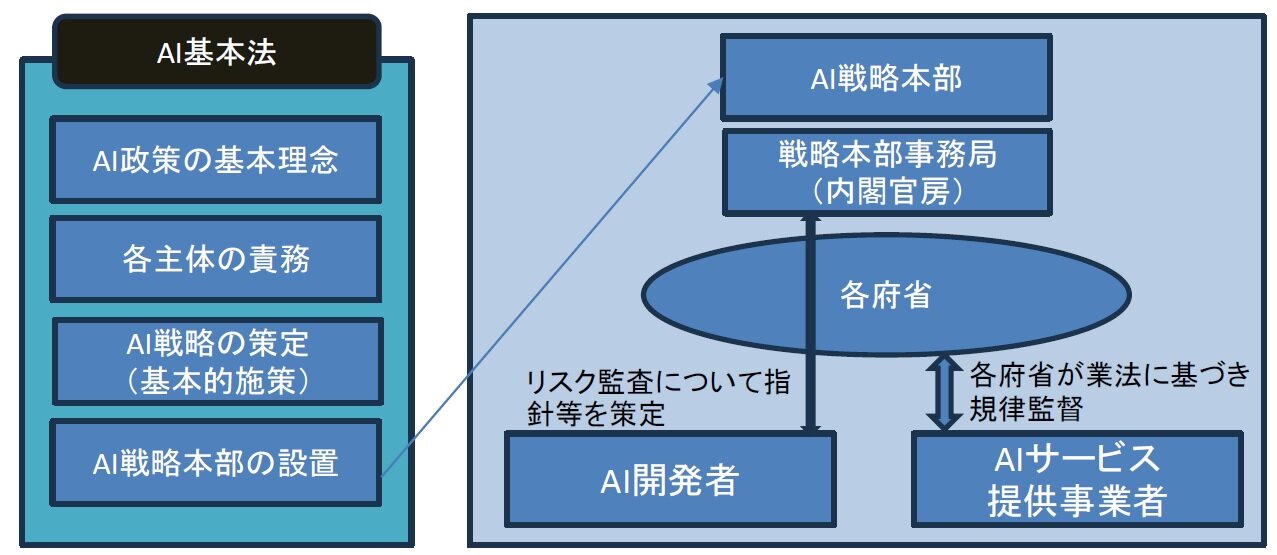

デジタル政策フォーラムは昨年12月、AI基本法の制定を主な内容とする「AIガバナンスの枠組みの構築に向けてVer2.0」を公表した。この中では欧州のようにリスク評価と規制の強弱をリンクさせることは現実的に運用が困難であり、開発意欲をそぐ可能性があるとした。その上で、開発者によるリスクの自主評価を基本としつつ、大規模なAIについては第三者によるリスク監査(評価)を実施することを提言している。

すでに独立行政法人・情報処理推進機構(IPA)の「AIセーフティ・インスティテュート (AISI)」が取り組んでいる脆弱(ぜいじゃく)性調査(red teaming)の具体化、AI生成物であることを示す電子透かしの導入などの推進についても方向性を示している。

また、AIの長所や利点を重視し、教育、医療のほか、環境対策、防災・減災、文化などでの積極的な活用が必要だとしている。AIにリスクがあるのは事実だが、だからといって先回りして使わない方向に向かうのではなく、リスクを認識・コントロールしながら積極的に活用する方向にかじを切ることが必要だろう。

リスク監査において第三者評価を入れる場合であっても、それは政府が行うのではなく、民間の中立的な機関が担うべきだろう。政府によるリスク管理は、政府にとって都合のよいAIの開発に偏る可能性があり、自由な開発という原則に影を落とす恐れがある。またAIのパフォーマンスはデータの質や量に依存することから、データ空間の健全性確保やオープンデータの積極的な推進も欠かせない。

こうしたAI関連の施策を推進していく上で、ハードロー(強制力を持つ法律など)としての規制の強弱をどのように設定するかという点が問題となる。参考になるのはサイバーセキュリティ基本法であり、この法律では直接的な規制ではなく、各府省の連携、官民協力など各主体の役割分担を明確化した上で、国全体の戦略を円滑に立てるサイバーセキュリティ戦略本部の設置という仕組みを構築した。AIの領域でも同様のアプローチを採り、国の戦略を円滑に推進するAI戦略本部を設置するなどの制度を整備することが必要だと考えている。

デジタル政策フォーラムが提言するAI規制の法体系と執行の仕組みの概要

デジタル政策フォーラムが提言するAI規制の法体系と執行の仕組みの概要

(出所)デジタル政策フォーラム「AIガバナンスの枠組みの構築に向けてver2.0」(2024年12月)

データベースではなく、「データ空間」を構築

――基本法を制定したら日本のAI開発、利用が問題なく進むとも思えない。

基本法の制定がすべての課題の解決策になるとは考えていない。求められるのは大きなビジョンを描くことではないか。AIの核をなす先進的な半導体開発、データの生成・利活用の促進、量子通信ネットワークの開発などは個々の要素がすべて関連性を持っている。部分最適に終わるのではなくシステムとして全体最適につなげていくためには、俯瞰(ふかん)的なデータ戦略を描くことが求められる。

こうしたデータ戦略の中で、AIは高速大容量のデータ処理・生成装置であると位置付けられる。また、俯瞰的なデータ戦略においてはデータを集中管理するデータベースのアプローチではなく、データの提供者と利用者の間を直接または仲介者経由でつないで取引を成立させるデータスペースを実現するための取り組みが極めて重要だ。

データ流通の取り組みは2020年の「データ戦略」に基づいて環境整備を進めているEUが大きく先行している。例えばEUが二酸化炭素(CO2)排出量削減の観点から試行を開始している炭素国境調整措置(CBAM)は、他国から輸入する物品について製造・流通過程におけるCO2排出量が基準値を越える場合に追加関税を課すなどの取り組みだ。こうしたデータ連携の基盤としてデータ流通基盤「GAIA-X」などのプロジェクトが複数動いているが、日本は同様の取り組みが遅れている。こうした分散型データ流通基盤を確立するための対策は官民連携プロジェクトとして早急に進めるべき大きな課題だろう。

データ分析するエンジニア(出所)Adobe Stock、生成AI作成

――現実には日本はAIどころか政府のデジタル化すら外資頼みでは。

政府が進める「ガバメントクラウド」について、現時点では米国系の大手クラウド事業者に依存する形になっている。重要なのはデータを日本国内に保存しているということだけではなく、そのクラウドの運用管轄権を国内でしっかり握る「データ主権」の確立にある。クラウドの運用管轄権が国内にない場合、何か問題が生じた時に対応が難しい。

特にクラウドの運用管轄が海外クラウド事業者の本国で行われている場合は対応が遅れる可能性があることに加え、政府が是正措置などを命令しても国外においては実効性が確保されないおそれがある。機微(センシティブ)性の高いデータを守るという経済安全保障の観点から考える必要がある。

ネットワーク化で社会に影響

――生成AIの進歩は早い。開発を独占する米巨大IT企業に経済社会を牛耳られる懸念は?

デジタル政策フォーラムの提言においても、AI開発の細かいルールは必要ではなく、昨年9月に欧州評議会が策定したAI国際条約(日本は現時点で未批准)にのっとり、基本的人権の保護、民主主義の確立、法の支配といった普遍的な価値観に抵触しない限り開発の自由が保障されるようにする必要がある。大規模なAIであるからといって規制の水準を高めることはAI法の文脈の中では必要ない。

この点はプラットフォーマーが既存ビジネス領域で有している市場支配力がAI開発の領域でも乱用されないかという競争法の観点から必要な規制のあり方を考えるべきだろう。

またAIというと、大規模言語モデル(LLM)に焦点が当たりがちだが、AIがネットワークを介して相互に接続する分散型モデルなど、多様なAIモデルが登場するような環境を想定しながら議論を進めたい。インターネット関連技術もそうだが、デジタル領域では集中と分散の歴史が繰り返されている。集中か分散かを二項対立で捉えるのではなく、両者の適正なバランスがどのように実現するかという観点から議論していく必要があるのではないか。

――AI開発の遅れへの対策は?巻き返しには何が必要か。

繰り返しになるが、多様なAIモデルの開発を促すべきだろう。LLMの世界で米国系の先行モデルに対抗していくことは現実的ではない。ネットワーク化された分散型AIやパーソナルAIの世界に商機を見いだしつつ、これらとLLMとの連携の可能性を模索していく必要がある。

米国では巨額なリスクマネーの供給が非連続なイノベーションを生み出している。リスクマネーの供給が日本では官民ともに不足している。こういう現状も変えていく必要がある。

注1 日本の AI 事業者ガイドライン概要

(1) ⼈間中⼼(⼈間の尊厳及び個⼈の⾃律を尊重する)

(2) 安全性(ステークホルダーの⽣命・⾝体・財産に危害を及ぼさない)

(3) 公平性(⼈種、性別、国籍、年齢、政治的信念、宗教等の多様な背景を理由とした不当で有害な偏⾒及び差別をなくすよう努める)

(4) プライバシー保護(係法令の遵守)

(5) セキュリティ確保(不正操作によって AIが意図せぬ変更⼜は停⽌が⽣じないことが重要)

(6) 透明性(検証可能性を確保し、ステークホルダーに対し合理的な範囲で情報を提供する)

(7) アカウンタビリティ(AI システム・サービスのもたらすリスクの程度を踏また合理的な範囲の説明責任を果たす)

(8) 教育・リテラシー(AI の正しい理解及び社会的に正しい利⽤ができる知識・リテラシー・倫理感を持つために、必要な教育を⾏うことを期待)

(9) 公正競争確保(AI をめぐる公正な競争環境の維持に努めることが期待)

(10) イノベーション(社会全体のイノベーションの促進に貢献するよう努めることが期待)

(出所)総務省 HP より要約

注2 欧州のAI規制法の罰則概要

(1)各加盟国は、運営者による本規則の違反に適用される罰則およびその他の執行措置(警告や非金銭的措置を含む)に関する規則を定め、それが適切かつ効果的に実施されるように必要なすべての措置を講じる。罰則は、効果的、比例的かつ抑止力のあるものでなければならず、中小企業(スタートアップを含む)の利益や経済的持続可能性を考慮するものとする。

(2)AIの禁止行為に違反した場合、最大3500万ユーロ、または違反者が事業体である場合には、前年度の全世界年間総売上高の7%のいずれか高い額(大企業が対象)。

(3)通知機関に関連する条項に違反した場合、行政罰金として最大1500万ユーロ、または違反者が企業である場合、前年度の全世界年間売上高の3%のいずれか高い額(大企業が対象)。

(4)通知機関や国内の管轄当局への回答において、不正確、不完全、または誤解を招く情報を提供した場合、行政罰金として最大750万ユーロ、または違反者が企業である場合、前年度の全世界年間売上高の1%のいずれか高い方(大企業が対象)。

(出所)EUのAI規制法から抜粋

タグから似た記事を探す

記事タイトルとURLをコピーしました!

研究員 河内 康高 主席研究員 小林 辰男